接着上篇,继续写一些我在巴西的见闻。

其实,这周主要是在圣保罗出差,所以可写的东西并不是很多。巴西当地的同事确实非常热情,带着我们在两个办公楼都转了转,并且安排了一堆的会议。大家都表示之前还是聊得太少了,我们做的很多功能,巴西这边都不知道;巴西同事的很多需求,我们也没有get到细节,有种相见恨晚的感觉。不过这其实情有可原,毕竟有11个小时到时差,沟通确实会受限。

这里不说太多工作的事情了(大家肯定也不是来看这个的),有个有意思的事情是:这边吃饭都流行AA,我们和巴西同事吃饭,也都是AA,唯一一顿被请客,还是因为巴西这边有个过来轮岗的中国人(她叫曼谷,在此特别感谢🙏)和我们一起吃了个饭。这都是文化如此,倒也无可厚非。

桑托斯

周六,终于空下来了,我们租了个车,去了趟桑托斯。

桑托斯,这边的葡语叫Santos,是圣保罗下面的一个港口城市,从圣保罗开车过来,要一个多小时。这座城市,以咖啡和贝利(球王)而闻名,因此,主要的景点就是:咖啡博物馆和贝利博物馆。

点击查看全文 »

发表于:2026年01月26日 06:32 | 分类: 游记 | 没有评论 »

书接上回,我们在里约短暂休整以后,就到本次行程的重点了,那就是:圣保罗出差!对,其实我们本次是商务出行,哈哈。

截止到写这文章的时候,已经在公司上了两天班了,加上时差还没倒利索,经常处在困困的状态。而且也还完全没有时间出去玩。因此,我想只写一写圣保罗的交通状况。

如果用一个字形容圣保罗的交通,那肯定就是“堵”了,以我的感觉来看,比国内的北京、杭州等著名堵城都还要更堵一些。翻了一下我的Uber行程,今天的两个单子,分别是 3.6km和7.7km,在上下班期间,分别用了 31分钟和43分钟,上班高峰期的时速不到7km/h,真的没有走路快!

我观察了一下,这么慢的原因,除了人多、车多以外,还有一个非常不利的因素:红绿灯多。

我目测有些路段大概两三百米就有一个红绿灯。

再究其根因,我觉得是这边没有类似国内的“小区”的感念,基本上一栋楼就是一个小区,然后一栋楼就不会特别大,所以基本上整个地块就分割成了非常小的正方形,这些正方形的边,自然就是大马路了;而那些顶点上,就都是红绿灯了。

虽然有不少新闻,说到圣保罗实施了类似国内“绿波带”的智能信号灯系统,但我感觉情况还是非常糟糕的。

另外,这边的车道设置也非常有意思,下图是从谷歌街景截的,从马路中间到最右边分别是:自行车道、绿化带、车道、摩托车道、车道、车道、车道、绿化带、人行道;看着虽然非常严谨,但也解决不了拥堵问题!

那么,有没有解决办法呢?或者说,富人有没有解决拥堵问题的招呢?答案当然是有的,只要使用钞能力!坐直升飞机上班就好了嘛!在圣保罗的CBD,写字楼集中区域,很多办公楼的楼顶都是停机坪,至少老板们是不用为堵车发愁的,哈哈!

发表于:2026年01月22日 09:26 | 分类: 游记 | 没有评论 »

里约热内卢,简称里约。但这并不是巴西的首都,同样的,圣保罗也不是巴西的首都。至于巴西的首都是哪?我并没有打算告诉你,你自己去查,嘿嘿!

我们的南美之旅,第一站就在这座城市了!

经过接近24小时的飞行,我们来到了这座一听就很热情、奔放的城市。你要问我第一印象是什么的话,我会说:热。35度左右的气温,如果有太阳的话,即使在新加坡待习惯了的我,也还是觉得有点热的。

我们是在Airbnb上定的房子,这个房子的风景非常赞👍,以至于我舍得放3张图,哈哈!

点击查看全文 »

发表于:2026年01月20日 08:45 | 分类: 游记 | 没有评论 »

从今天开始,未来的两周都将在南美洲度过。

我先会在巴西出差一周,再去阿根廷玩一周。此前我也从未涉足南美,也不知道接下来会遇到什么。

我将在这里不定期更新一下南美的见闻。但大概是以流水账为主,但贵在真实。

我是凌晨从新加坡出发的,机票是从迪拜中转的emirates航空的,发现樟宜机场的自助值机这次终于能正常使用了,试了下居然顺利取到了登机牌,而且选的还是比较好的twin seats(见后图)。

点击查看全文 »

发表于:2026年01月17日 02:32 | 分类: 流水帐, 游记 | 没有评论 »

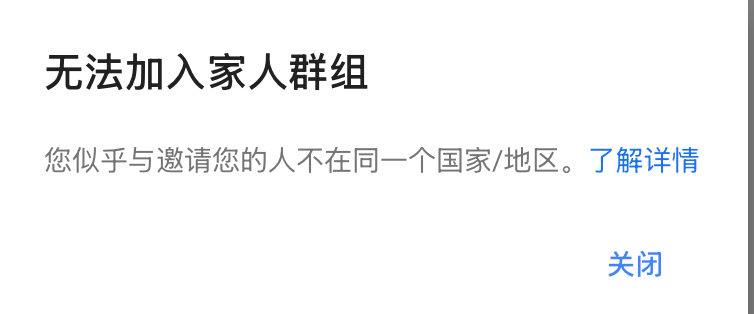

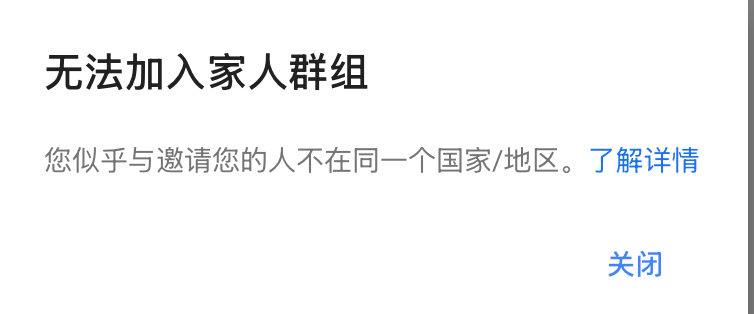

如果你买过YouTube premium,或者加过其他人买的YouTube premium family套餐,后续又因为种种原因(比如Google 封禁了假的土耳其区等)退出了premium计划,那你再想加入另一个family的时候,大概率会看到这么一个提示:告诉你“您似乎与邀请您的人不在同一个国家/地区。”,从而“无法加入家人群组”。

然后,你可以会在Google账号的后台管理账号做各种尝试,包括用不同国家的VPN,拿到特定的IP地址、修改账号的住址信息、添加不同国家的信用卡作为付款方式等等,但我猜这大概率都解决不了你的问题!

我曾经也因此折腾了很久,知道最近,才明白怎么查看以及修改这个字段。先说好:方法仅供参考,也别拿大号玩得太花,不然被封就嘎了~

查看:

先得有办法确认当前的账号所属国家,才知道要不要去做修改。

这个方法很简单,登陆Google Play的web页面,登陆以后,确定右上角的头像是要查看的账号头像,然后把页面拉到最底部,右下角就会显示 国家(语言)。

这可能是唯一精确知道目前账号所属国的办法。

修改:

如果确定了你的国家不是你想要的,要怎么修改呢?

以下几乎也是唯一可行的办法:

点击查看全文 »

发表于:2026年01月14日 21:03 | 分类: 经验技巧 | 3 个评论 »

在读完《人类群星闪耀时》之后,我就开始读这本《静静的顿河》了,由于此书篇幅比较大,我不想整本读完再写读后感,所以,就在看完前两卷之后,就先来水这么一篇了。

要读懂《静静的顿河》首先得理解一个概念,因为会在书中反复出现,那就是“哥萨克”,这个概念基本是就是指 俄国南部边疆地区(顿河就在这个地区)的半军事化自由民群体。他们介于农奴和军人之间,闲时务农、战时为兵,或者一个家庭会出部分“壮丁”去当兵,以维持这个小团体的利益。

作者肖洛霍夫,自己就是出生于顿河地区的哥萨克家庭,所以,某种意义上来说,这本书并不是虚构的小说,而是纪实文学,或者干脆是回忆录。当然,在此书获得诺贝尔文学奖之后,很多人都对书中情节的真实性提出质疑,但无法质疑的是此书的文学地位。

这种文学性,也会体现在它描述的“画面感”上,书中描写的顿河地区的景色,在我脑海里是那种“冬天的江南平原”的景色,水草丰美的鱼米之乡,适合放牧耕种,但天气略微偏冷一些。人民的生活属于清贫但又充实的,除了偶尔会被召唤入伍以外,基本上也是挺幸福的。

也体现在细腻的人物刻画上,会通过大量的对白,以及心理活动的描写,把一个个人物刻画地栩栩如生。我觉得,如果要拍电影或者电视剧的话,基本上只需要小小的修改,就可以直接当作演出脚本使用了。

由于以上原因,加上中文译者(金人)的水平也很高,这本书读起来相对很舒服,就像是看一部情节缓缓推进的电影,经常会有停不下来的感觉。

当然,前两卷基本上还处于交代背景、铺垫人设的阶段(我感觉是这样),虽然已经出现了马克思,但只是刚刚提起一点点。大部分内容都是家长里短、儿女情长这类。我还挺期待这样一个葛利沙,在后续的战争、革命等社会巨变面前,会产生什么戏剧性的冲突,我会拭目以待!

点击查看全文 »

发表于:2026年01月11日 23:07 | 分类: 读书笔记 | 没有评论 »

过度医疗似乎是发达国家的通病,之前有听说美国、欧洲都有这种情况,以诊疗费用为目的过度医疗,而且在这个领域,由于信息差巨大,病人几乎没有办法讨价还价。巨额诊疗费和保险一起,构成了一个很别扭的存在。

今天我也算是亲身体验了一把新加坡的过度医疗。

起因是我家娃左脚的大拇指长了嵌甲,一年多了,那指甲长出来的时候就会戳到边上的肉,有时候还会红肿化脓,自己也试过很多办法都没有根治,好一阵坏一阵的,感觉也不是个事,于是就带着去小诊所看了一下,医生表示这个搞不定,需要介绍到大医院去看下。

于是经过排队,上周看到了专家医生,说是要动个小手术,把部分组织切除。而且也不能当场手术,需要再预约时间。

我们觉得也算合理,就约到了今天10点去做手术。至此都挺正常的。

今天一早,我们就去医院了,想着应该可以赶回来吃午饭吧。10点准时到了以后,接待的人已经提前把上下文了解了,这点体验非常好,开了手术的单子,并且把术后的消炎、镇痛的药都给我们以后,说手术的地点是另一个分院,已经帮我们预约了11点的时间,还得让我们赶过去一趟,因为那边的费用会便宜一些。

那好吧,我们就赶到新的地方,再经过登记、缴费等流程,就由护士引导到病房里,说要换衣服。自此,画风就有点不对劲了。

点击查看全文 »

发表于:2026年01月10日 21:46 | 分类: 流水帐 | 没有评论 »

提交过SGAC的朋友,也许会注意到它会问你有没有去过一些特点的国家,国家列表一般处于非洲和南美洲,这些国家就是黄热病的风险区。从这大张旗鼓的架势,就知道这病应该不简单,所以,让GPT一句话科普了一下黄热病:

黄热病是一种主要通过伊蚊叮咬传播的急性病毒性传染病,流行于非洲和南美洲的热带和亚热带地区,感染后可出现发热、头痛、肌肉痛、恶心呕吐等症状,部分患者会进展为黄疸、出血和多器官衰竭,病死率较高,但目前已有安全有效的减毒活疫苗,接种一次即可提供长期甚至终身保护。

由于马上要去巴西,新加坡政府规定是必须要打黄热病疫苗的,否则到时候再入境就要被拉去隔离了。今天突然想起此时,急匆匆了解了一下,由于疫苗打了以后要10天才能生效起到保护作用,我的时间已经有点不够了,所以以最快的速度搞定了,这里记录一下,也许能给大家做个参考。

新加坡其实有不少机构都可以打疫苗,我是在这里预约的,一般能预约到当天。在差不多的时间过去门店,跟他说要打黄热病疫苗,在确认身份之后,他们会简单问你一些信息,比如有没有药物过敏之类的,就直接可以打了。

打的是这个,翻译了一下,是法国产的疫苗:

点击查看全文 »

发表于:2026年01月09日 22:57 | 分类: 流水帐 | 没有评论 »

重庆这座城市,其实我并不是第一次来。2017年,开车去西藏的时候,就来过一次。但那次也仅仅算是“来过”而已,由于不是目的地,就纯粹只是路过一下。当时,应该是天黑才到的,然后在一个青旅住了一晚,第二天早上找了家重庆小面店,蹲在路边吃了一碗豌杂面,就继续赶路了。所以,正儿八经来玩的话,这也属于第一次。

这次来重庆,还是娃提议的。可能是在新加坡吃得过于清淡了吧,说是想吃国内的火锅了,然后由于不知道啥时候欠了他“奖励”,说就拿重庆之行来抵了,于是在这个圣诞期间机票最贵的时段,我们来到了重庆。

吃喝这方面,重庆太能打了,美食是真的不错!尤其适合喜欢吃辣的人,比如我们一家。品种非常丰富,而且感觉随便进一家店都不怎么会踩雷,各种火锅、麻辣串串、烧烤、酸辣粉、重庆小面、拇指大的包子、红糖糍粑什么的,真的太丰富了。然后,不知道是不是因为日照时间少(重庆气候多阴雨,比较潮湿),重庆人除了爱吃辣,也很喜欢喝奶茶。市区的奶茶店密度非常高,有时候甚至隔条马路面对面就能开两家同一个品牌的奶茶店。蜜雪、茶姬、茶颜悦色、古茗是看到最多的几个牌子。

玩乐这块,重庆也是实力型选手,山城的地貌名不虚传,比较典型的是魁星楼(其实是个医院)后面有个挺大的广场,广场的水平面就是隔壁楼的21楼。这样的地貌其实到处可见,我们酒店所在的楼,电梯里的1楼和-8楼,出来都是马路。。。

也去了几个景点,比如解放碑(推荐)、李子坝地铁站(不错)、洪崖洞(晚上去)、山城步道(推荐)、十八梯(一般)、两江夜游(性价比不高)、鹅岭栈道(可以去)、鹅岭公园(栈道出来顺便去)等。

点击查看全文 »

发表于:2025年12月28日 18:27 | 分类: 游记 | 没有评论 »

《人类群星闪耀时》是我继《显微镜下的大明》之后看的一本书。这本书有很多中译版本,不同年代有不少译者都翻译过,这从一个侧面反映出这应该是一本好书。而我看的是张玉书翻译的,人民文学出版社的版本。

本书的每章内容都是相互独立的,每章会记录一个人类历史上的关键转折点,比如发现新大陆、关键战役的局势变化(拜占庭的陷落和拿破仑的滑铁卢之战都属于这类)等。当然,这些历史事件全都是以作者茨威格这个19到20世纪的欧洲人的视野来呈现的,肯定不全面。

但说实话,这书我没有读得很仔细,现在回想,可能是因为两大原因吧。

其一,是这书的内容太过“艺术性”了,虽然不属于虚构文学,但几百年前的事情记录得如此翔实,并细节丰富,想必也是有不少“想象成分”的,加上堆砌的辞藻太过华丽,大量精美的排比,让我有点不适应。这点大概是我自己的品味太过“理工男”了。

其二,是书里记载的部分历史事件,我感觉离我的生活比较遥远,比如写尼采的那章,对我来说就非常地抽象。虽然我知道作者是想表达这是一个“发生在一个孤独思想者的神经系统”里的转折点,但还是很难看得下去。

尽管如此,大部分章节还是写得非常精彩的。挑几个我最感兴趣的,给大伙介绍一下。

拜占庭的陷落,这一章,属于我比较熟悉的。在《三体III·死神永生》里,开篇就是“公元1453年…魔法师之死…”,就对此事有一定的印象。后面我还读过《罗马人的故事》(PS:还有一篇西塞罗也和罗马人有关),对这段历史的来龙去脉就已经有了比较完整的了解了。加上2023年底,我还去事发地(伊斯坦布尔)跑了横跨亚欧大陆的土耳其马拉松,就更有感觉了。

比较哲学的说法,此事就是必然中的偶然,也是偶然中的必然。奥斯曼和东罗马两大帝国此起彼伏、斗争多年,肯定会在某个节点进行权力的交接,世界秩序势必会重组;但具体是在哪年,在哪个地方,又真的就是偶然。奥斯曼帝国的“舰队翻山”和拜占庭坚固城墙上那扇忘关的小门,都属于非常戏剧性的偶然了。

滑铁卢这章,其实也类似,书中表达的意思,多少对拿破仑由于错信了下属格鲁希、导致此次战役失利、最终导致整个战争的失败有些惋惜。但这又何尝不是因为拿破仑逐渐式微,几乎已无人可用,埋下的伏笔呢?

越过海洋的第一句话属于书中少有的科技类突破,在那个莫斯电码被大量运用到城际通信的年代,怎么铺设海底电缆连接欧美两个大陆,想想也确实是非常艰巨的任务。这属于那种投入巨大,风险巨大,但收益也巨大的科技项目,正如现在的火星移民计划。想想当时,再想想现在的海底光缆和星链卫星,是不是觉得能活在21世纪还蛮幸福的?

逃向上帝 和 密封列车这两章,都和俄罗斯的历史有关系,说实话之前对这个北方大国的历史了解确实不多,所以也不是太有感觉。后续我得补一补从沙皇到布尔什维克、从宗教化精神世界到革命意识形态的那段俄国历史,不然像托尔斯泰和列宁这样的人物,总觉得隔着一层。

争夺南极也非常有意思,有两支队伍在差不多的时间,都希望代表自己的国家,踏上这个从未有人类到达过的极点。为此也都付出了惨痛的代价。但这种追逐或者竞赛本身,有没有意义呢?这又是一个非常哲学的问题了。我们可以说:随着科技的发展,总有一天人类会有足够的实力来征服南极;但这一天不正是因为像斯各特和阿蒙森这样的人,在一点点逐步探索和突破人类的边界,才得以更快到来的么?正如现在科技的发展、体育的发展,也都是靠这么一批执着的人,在一点点的突破着!

关于此书,就先说这么多。

大家有什么好书推荐么?欢迎留言。

发表于:2025年12月20日 14:15 | 分类: 读书笔记 | 1 个评论 »